Flink中cdas整库同步是否支持sink段到kafka形成一个topic?目前我知道是不可以的,不知道未来会不会这样做,那就只能用datastream接入全部数据打入kafka单topic了,加解密数据,愁死人了,加解密还不让我们来操作 看来得看看paimon

看来得看看paimon

Flink中cdas整库同步是否支持sink段到kafka形成一个topic?目前我知道是不可以的,[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

Flink中cdas整库同步是否支持sink段到kafka形成一个topic?目前我知道是不可以的,不知道未来会不会这样做,那就只能用datastream接入全部数据打入kafka单topic了,加解密数据,愁死人了,加解密还不让我们来操作 看来得看看paimon

看来得看看paimon

根据您提供的信息,在 Flink 中使用 CDAS(Change Data Capture and Apply Service)进行整库同步,不支持将数据直接 sink 到 Kafka 形成一个 topic。目前的设计是所有表都混在一个 Kafka topic 中,这并不是一个很好的实践。

这种设计可能会导致几个问题:

1. 性能问题:由于无法进行谓词下推,所有的数据都需要被消费后才能进行分流,这可能会导致性能下降。

2. 数据分离问题:如果需要对不同的表进行不同的处理或分析,由于数据都混在一个 topic 中,可能需要更多的操作来区分和处理数据。

3. 运维管理问题:整库数据混在一个 topic 中,可能会增加运维复杂性,并且对于一些特定的收费或计费要求可能不符合。

在未来的版本中,Flink 可能会考虑支持更灵活的方式来进行整库同步,并提供更好的数据分流和管理机制。但具体的功能更新还需参考 Flink 官方文档和发布公告。

目前,如果您需要将整库数据按照表进行分流到不同的 Kafka topic 中,并进行加解密等操作,可以考虑使用 DataStream API 来手动处理数据,并将数据写入到不同的 Kafka topic 中。这样可以更灵活地进行数据处理和分发。

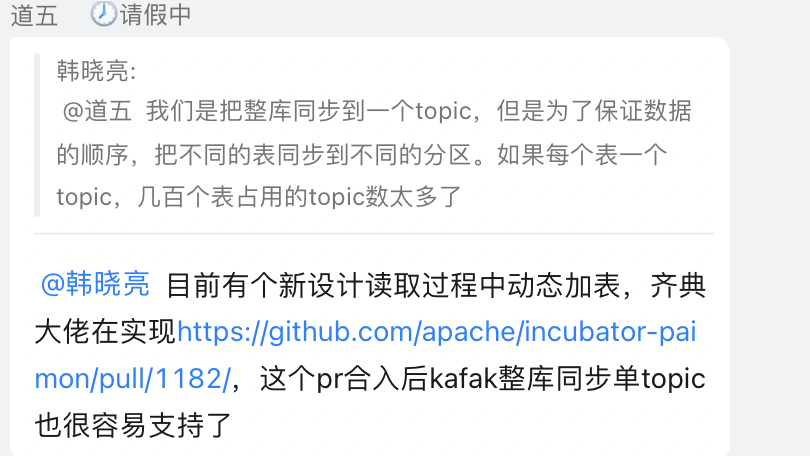

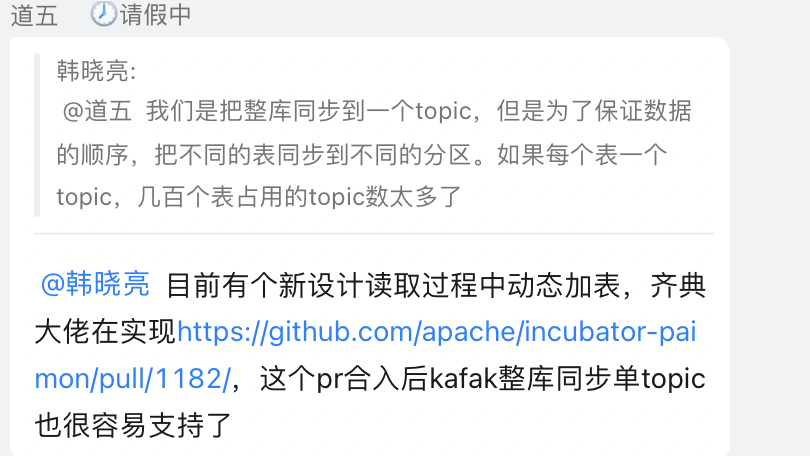

形成一个topic好像不行https://help.aliyun.com/document_detail/446799.html?spm=a2c4g.446796.0.0.64946102Hbrgbv整库同步任务建立的Kafka topic名称和MySQL表名相同,所有的表都混在一个topic里面,这个也不是很好的实践啊,毕竟kafka没办法谓词下推,都是消费出来才能分流的,topic其实如果不是运维要求(或者某些产品按照这个收费),多一些从性能上看不是大问题,此回答整理自钉群“实时计算Flink产品交流群”