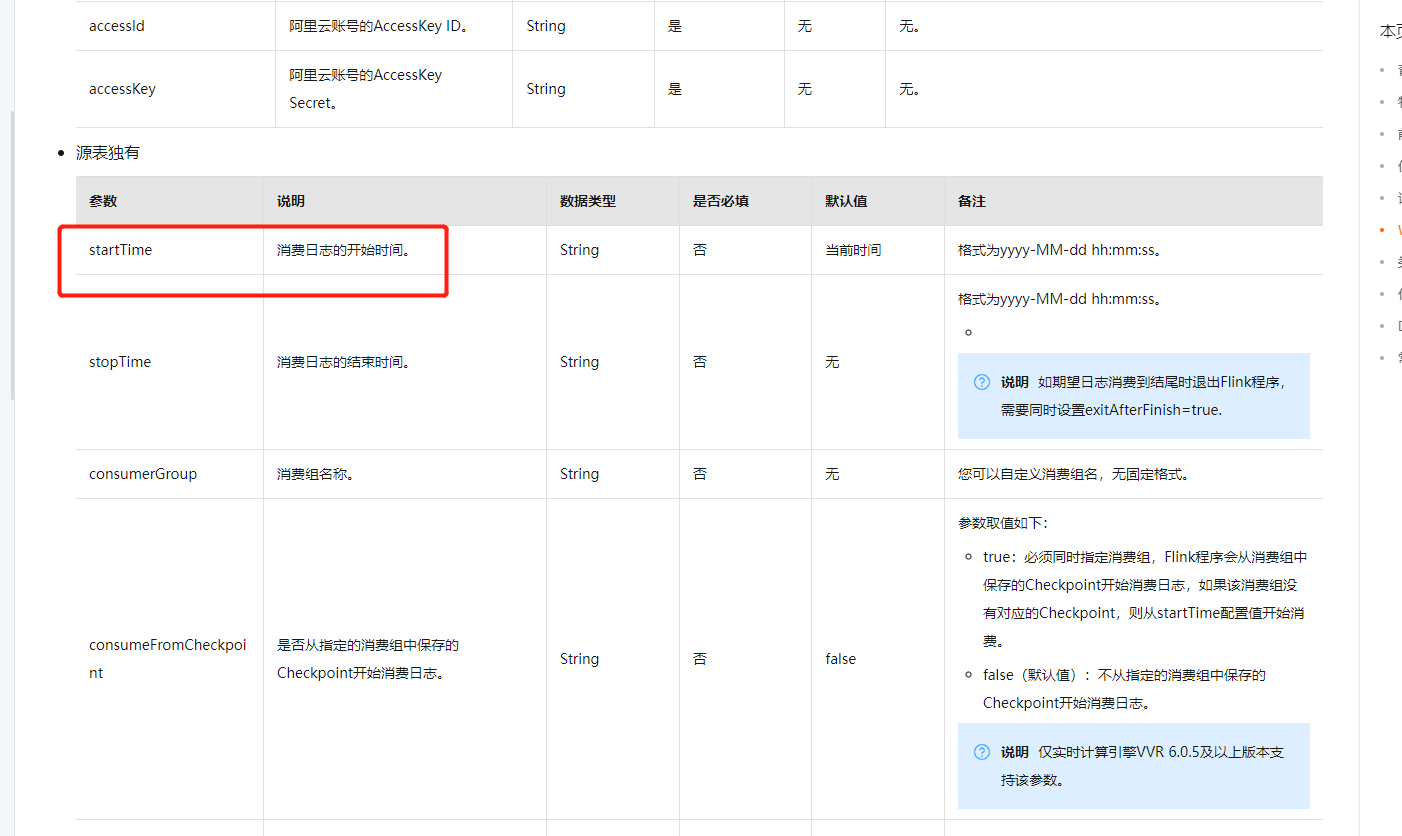

flink1.13.6消费sls日志服务数据发现每次都是全量消费 导致数据一直延迟 有没有大佬指点一下能不能从最新位置开始消费sls日志服务数据?flink-loghub-connector这个连接器谁有下载地址给一个,这个是sls的包 为啥我用starttime指定时间不好使啊

这里的starttime好像不好使

flink1.13.6消费sls日志服务数据发现每次都是全量消费 导致数据一直延迟 有没有大佬指点?[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

在 Flink 1.13.6 中,如果每次消费 SLS 日志服务数据都是全量消费,可能是因为以下原因之一:

启用了 Checkpoint:确保在 Flink 应用程序中启用了检查点(Checkpoint)机制。检查点可以帮助记录消费的进度和状态,以在故障恢复后从断点处继续消费。

指定了 Savepoint:如果在启动 Flink 应用程序时指定了保存点(Savepoint),应用程序将从此保存点开始消费。请确保指定的保存点是正确的,并且不会导致从头开始的全量消费。

设置了 GroupID:在连接到 SLS 日志服务时,使用正确的 Consumer Group ID 进行连接。Consumer Group ID 可以帮助 Flink 追踪每个消费者的进度,并确保只消费新增的数据。

配置了 SLS Connector 的 Parallelism:检查 SLS Connector 的并行度设置,假如并行度设置过高,可能导致多个任务同时消费相同的数据,产生重复消费或全量消费的现象。

使用正确的读取模式:确保正确配置了 Flink CDC 连接器的读取模式。有两种常见的读取模式:

earliest-offset和latest-offset。前者从最早的日志数据开始消费,而后者从最新的日志数据开始消费。根据需求选择适当的读取模式。检查 SLS 配置:确保 SLS 日志服务的配置正确,特别是 Logstore 的

shard和offset等参数。可通过调整这些参数来确保 Flink 只消费增量数据,而不是全量数据。在 Flink 中,如果您使用了 SLS(日志服务)的源来消费数据,每次都是全量消费数据是不正常的,可能是由于以下原因导致的:

SLS 源配置错误:如果 SLS 源的配置不正确,可能会导致 Flink 每次启动都从头开始消费数据。您可以检查 SLS 源的配置,确保配置正确,例如检查起始时间、结束时间、消费组等参数是否正确。

消费者组重复:如果多个 Flink 应用程序使用相同的消费者组来消费 SLS 数据,可能会导致数据被重复消费。在这种情况下,您可以使用不同的消费者组来消费数据,以避免重复消费。

SLS 数据异常:如果 SLS 中的数据发生异常,例如数据重复、数据丢失等问题,也可能会导致 Flink 每次都需要从头开始消费数据。在这种情况下,建议您检查 SLS 中的数据异常情况,例如检查数据是否重复、数据是否丢失等问题。

https://mvnrepository.com/artifact/com.alibaba.ververica/ververica-connector-sls

https://help.aliyun.com/zh/flink/developer-reference/log-service-connector?spm=a2c4g.11186623.0.0.42cb6806dkRtw3没用过,我只给你连接器,此回答整理自钉群“【③群】Apache Flink China社区”